最近家里宽带换成了北京联通20M,相比之前的宽带通,质量确实高了不少,国外网站和公司vpn的速度明显快了很多。但比较奇怪的是自己搭在DigitalOcean上的Shadowsocks速度没有太大提升,有时反而还不如以前。

首先公司网络里测试Shadowsocks的时候速度比较理想,也非常稳定,说明不是DigitalOcean的问题;自己家里上国外网站速度明显快了不少,而且只要能访问的网站速度都比较快,说明北京联通也没有问题。那问题只可能是北京联通与DigitalOcean之间水土不服了。

之前自己的vps一直放在DigitalOcean的旧金山机房,因为国内这个机房的口碑普遍比较好。但在家里打开newnaw.com和自己博客的时候也能感觉到速度不如以前了,难道是联通到这个机房度的问题?ping了一下DigitalOcean在旧金山的测速页面:

11%丢包率,平均响应也都在310ms以上……感觉联通到旧金山机房确实有问题,看看其他的机房吧。DigitalOcean去年在亚洲开通了新加坡机房,但之前就看到过,据说到国内的速度不稳定,还不如其他机房。抱着试试看的心态,也ping了一下新加坡的测速页面:

11%丢包率,平均响应也都在310ms以上……感觉联通到旧金山机房确实有问题,看看其他的机房吧。DigitalOcean去年在亚洲开通了新加坡机房,但之前就看到过,据说到国内的速度不稳定,还不如其他机房。抱着试试看的心态,也ping了一下新加坡的测速页面:

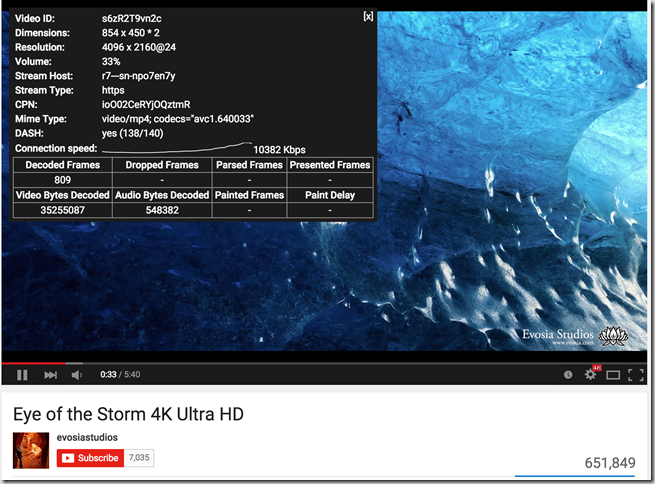

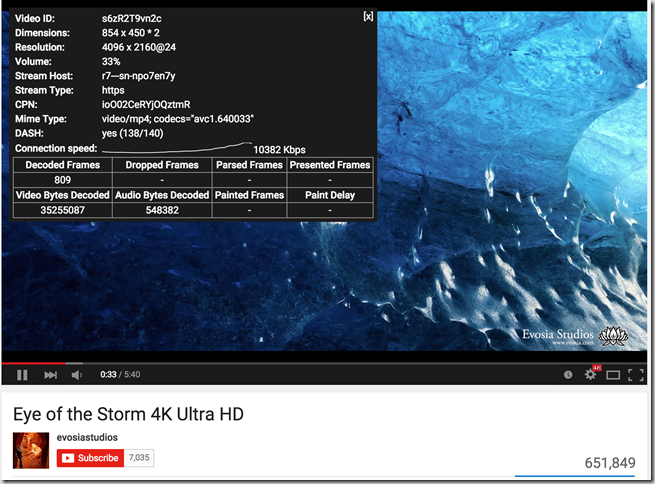

平均响应时间172ms,快了几乎一倍。立刻去新建了一个vps,机房选择新加坡,之后上面部署了Shadowsocks测试了一下速度,youtube的4k视频都可以流畅观看了,有点小感动…

平均响应时间172ms,快了几乎一倍。立刻去新建了一个vps,机房选择新加坡,之后上面部署了Shadowsocks测试了一下速度,youtube的4k视频都可以流畅观看了,有点小感动…

测试后发现Shadowsocks的速度比较稳定,于是就在DigitalOcean上创建snapshot,转移之到新加坡机房,重建vps…整个操作很简单,DigitalOcean便利性还是很好的。

测试后发现Shadowsocks的速度比较稳定,于是就在DigitalOcean上创建snapshot,转移之到新加坡机房,重建vps…整个操作很简单,DigitalOcean便利性还是很好的。

后来又用traceroute试了一下新加坡机房的测试页面,发现并不像网上所说,会先绕去北美一圈,然后才到新加坡,而是直接从日本到了新加坡:

那单从传输距离来说,新加坡明显还是比旧金山近很多,也就解释了为什么新加坡机房速度会比较快了。

Shadowsocks是国内的clowwindy写的工具,在goagent沦陷,ssh速度偏慢的情况下确实给大家带来了非常大的便利。前两天中文维基百科也不能愉快地从国内访问了,借网络上一张图看看,世界前30的网站我们还能上几个……希望这已经是最坏的时候了。